بهینه سازی موتورهای جستجو، در ابتدایی ترین م،ای آن، بیش از هر چیز بر یک چیز متکی است: ،کبوت های موتورهای جستجو در حال ،یدن و نمایه سازی سایت شما هستند.

اما تقریباً هر وب سایتی صفحاتی دارد که شما نمی خواهید در این کاوش قرار دهید.

به ،وان مثال، آیا واقعاً می خواهید خط مشی رازداری یا صفحات جستجوی داخلی شما در نتایج Google نمایش داده شوند؟

در بهترین حالت، اینها هیچ کاری برای هدایت فعالانه ترافیک به سایت شما انجام نمی دهند و در بدترین حالت، می توانند ترافیک را از صفحات مهم تر منحرف کنند.

خوشبختانه، گوگل به مدیران وبسایتها اجازه میدهد تا به رباتهای موتور جستجو بگویند که چه صفحات و محتوایی را ب،ند و چه مواردی را نادیده بگیرند. راه های مختلفی برای انجام این کار وجود دارد، رایج ترین آنها استفاده از فایل robots.txt یا تگ متا ربات است.

توضیحی عالی و مفصل در مورد نکات و نکات مربوط به robots.txt داریم که حتما مطالعه کنید.

اما در سطح بالا، این یک فایل متنی ساده است که در ریشه وب سایت شما قرار دارد و از پروتکل حذف روبات ها (REP).

Robots.txt به ،ندهها دستورالعملهایی درباره سایت به،وان یک کل ارائه میکند، در حالی که بر،بهای متا روباتها شامل دستورالعملهایی برای صفحات خاص هستند.

برخی از تگ های متا ربات که ممکن است از آنها استفاده کنید شامل می شوند فهرست مطالب، که به موتورهای جستجو می گوید صفحه را به فهرست خود اضافه کنند. noindex، که به آن می گوید صفحه ای را به فهرست اضافه نکند یا آن را در نتایج جستجو قرار ندهد. دنبال ،، که به موتور جستجو دستور می دهد پیوندهای موجود در یک صفحه را دنبال کند. nofollow، که به آن می گوید پیوندها را دنبال نکند، و کلی از موارد دیگر.

هر دو بر،ب robots.txt و meta robots ابزارهای مفیدی برای نگهداری در جعبه ابزار شما هستند، اما راه دیگری نیز برای آموزش ربات های موتور جستجو به noindex یا nofollow وجود دارد: X-Robots-Tag.

تگ X-Robots چیست؟

X-Robots-Tag راه دیگری برای کنترل نحوه ،یدن و نمایه شدن صفحات وب شما توسط ،کبوت ها است. به ،وان بخشی از پاسخ هدر HTTP به یک URL، نمایه سازی کل صفحه و همچنین ،اصر خاص در آن صفحه را کنترل می کند.

و در حالی که استفاده از تگ های متا روبات ها نسبتاً ساده است، X-Robots-Tag کمی پیچیده تر است.

اما این البته این سوال را ایجاد می کند:

چه زم، باید از تگ X-Robots استفاده کنید؟

مطابق با گوگل، “هر دستورالعملی که می تواند در متا تگ ربات استفاده شود می تواند به ،وان X-Robots-Tag نیز مشخص شود.”

در حالی که میتو،د دستورالعملهای مربوط به robots.txt را در سرفصلهای یک پاسخ HTTP با تگ متا روبات و تگ X-Robots تنظیم کنید، موقعیتهای خاصی وجود دارد که میخواهید از X-Robots-Tag استفاده کنید – دو رایجترین آنها. بودن زم، که:

- شما می خواهید نحوه ،یدن و نمایه شدن فایل های غیر HTML خود را کنترل کنید.

- شما می خواهید دستورالعمل ها را به جای اینکه در سطح صفحه ارائه کنید، در سراسر سایت ارائه دهید.

برای مثال، اگر میخواهید ،یدن یک تصویر یا ویدیوی خاص را مسدود کنید، روش پاسخ HTTP این کار را آسان میکند.

هدر X-Robots-Tag نیز مفید است زیرا به شما امکان می دهد چندین تگ را در یک پاسخ HTTP ،یب کنید یا از لیستی از دستورالعمل ها جدا شده با کاما برای تعیین دستورالعمل ها استفاده کنید.

شاید شما نمی خواهید صفحه خاصی ذخیره شود و می خواهید بعد از تاریخ خاصی در دسترس نباشد. میتو،د از ،یبی از تگهای «noarc،e» و «unavailable_after» استفاده کنید تا به رباتهای موتور جستجو دستور دهید این دستورالعملها را دنبال کنند.

اساسا، قدرت X-Robots-Tag این است که بسیار انعطاف پذیرتر از تگ متا روبات است.

مزیت استفاده از یک X-Robots-Tag با پاسخهای HTTP این امکان را به شما میدهد که از عبارات منظم برای اجرای دستورالعملهای ،یدن در غیر HTML و همچنین اعمال پارامترها در سطح بزرگتر و جه، استفاده کنید.

برای کمک به درک تفاوت بین این دستورالعمل ها، دسته بندی آنها بر اساس نوع مفید است. ی،ی دایرکتیوهای ،نده هستند یا دایرکتیوهای نمایه ساز؟

در اینجا یک برگه تقلب مفید برای توضیح وجود دارد:

| دستورالعمل های ،نده | دستورالعمل های نمایه ساز |

| Robots.txt – از دستورالعملهای عامل کاربر، اجازه، غیرمجاز و نقشه سایت استفاده میکند تا مشخص کند رباتهای موتور جستجوی سایت در کجا مجاز به ،یدن هستند و اجازه ،یدن ندارند. | تگ متا روبات ها – به شما امکان می دهد موتورهای جستجو را مشخص کنید و از نمایش صفحات خاصی در یک سایت در نتایج جستجو جلوگیری کنید.

Nofollow – به شما امکان می دهد پیوندهایی را مشخص کنید که نباید به اعتبار یا PageRank منتقل شوند. تگ X-Robots – به شما امکان می دهد نحوه نمایه سازی انواع فایل های مشخص شده را کنترل کنید. |

بر،ب X-Robots را کجا قرار می دهید؟

فرض کنید می خواهید انواع فایل های خاصی را مسدود کنید. یک رویکرد ایده آل اضافه ، X-Robots-Tag به پیکربندی آپاچی یا فایل htaccess.

X-Robots-Tag را می توان از طریق فایل htaccess. به پاسخ های HTTP سایت در پیکربندی سرور آپاچی اضافه کرد.

مثالها و کاربردهای واقعی X-Robots-Tag

بنابراین از نظر تئوری عالی به نظر می رسد، اما در دنیای واقعی چگونه به نظر می رسد؟ بیا یک نگاهی بیندازیم.

فرض کنید میخواستیم موتورهای جستجو انواع فایلهای pdf را ایند، نکنند. این پیکربندی در سرورهای آپاچی چیزی شبیه به شکل زیر است:

<Files ~ "\.pdf$"> Header set X-Robots-Tag "noindex, nofollow" </Files>

در Nginx، به شکل زیر است:

location ~* \.pdf$ {

add_header X-Robots-Tag "noindex, nofollow";

}

حالا بیایید به سناریوی متفاوتی نگاه کنیم. فرض کنید می خواهیم از X-Robots-Tag برای جلوگیری از نمایه شدن فایل های تصویری مانند jpg، .gif، .png و غیره استفاده کنیم. شما می تو،د این کار را با یک X-Robots-Tag که شبیه زیر است انجام دهید:

<Files ~ "\.(png|jpe?g|gif)$"> Header set X-Robots-Tag "noindex" </Files>

لطفاً توجه داشته باشید که درک نحوه عملکرد این دستورالعمل ها و تأثیر آنها بر یکدیگر بسیار مهم است.

برای مثال، چه اتفاقی میافتد اگر هر دو تگ X-Robots-Tag و متا روباتها زم، که رباتهای ،نده URL را کشف میکنند، قرار بگیرند؟

اگر آن URL از robots.txt مسدود شده باشد، دستورالعملهای نمایهسازی و سرویسدهی خاصی را نمیتوان کشف کرد و دنبال نمیشوند.

اگر قرار است دستورالعملها دنبال شوند، URLهای حاوی آنها را نمیتوان از ،یدن منع کرد.

یک بر،ب X-Robots را بررسی کنید

چند روش مختلف وجود دارد که می توان برای بررسی وجود X-Robots-Tag در سایت استفاده کرد.

ساده ترین راه برای بررسی نصب a ،د مرورگر که اطلاعات X-Robots-Tag را در مورد URL به شما می گوید.

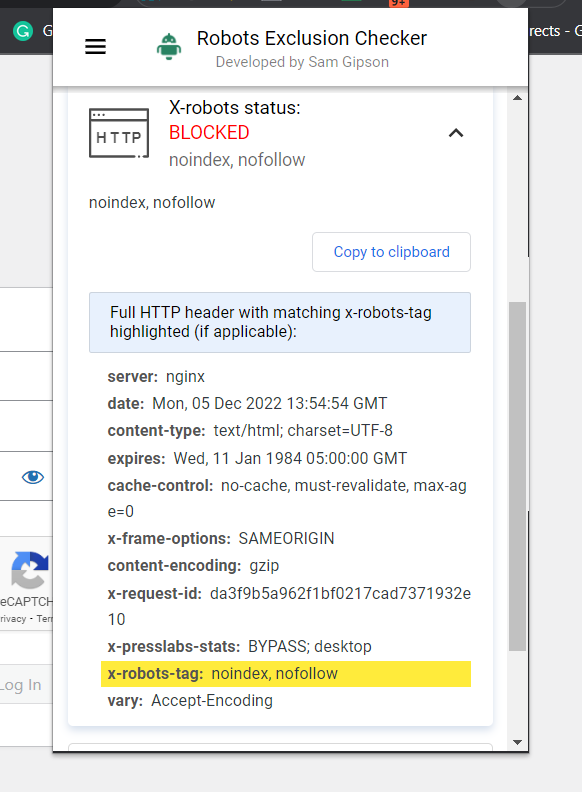

اسکرین شات از Robots Exclusion Checker، دسامبر 2022

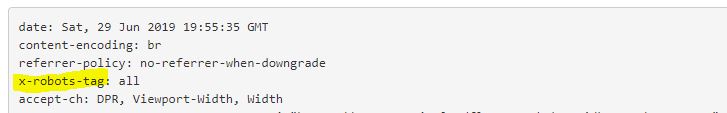

اسکرین شات از Robots Exclusion Checker، دسامبر 2022افزونه دیگری که می تو،د برای تعیین اینکه آیا X-Robots-Tag در حال استفاده است یا خیر، استفاده کنید، این است افزونه توسعه دهنده وب.

با کلیک بر روی افزونه در مرورگر خود و رفتن به «مشاهده سرصفحههای پاسخ»، میتو،د سرصفحههای مختلف HTTP را مشاهده کنید.

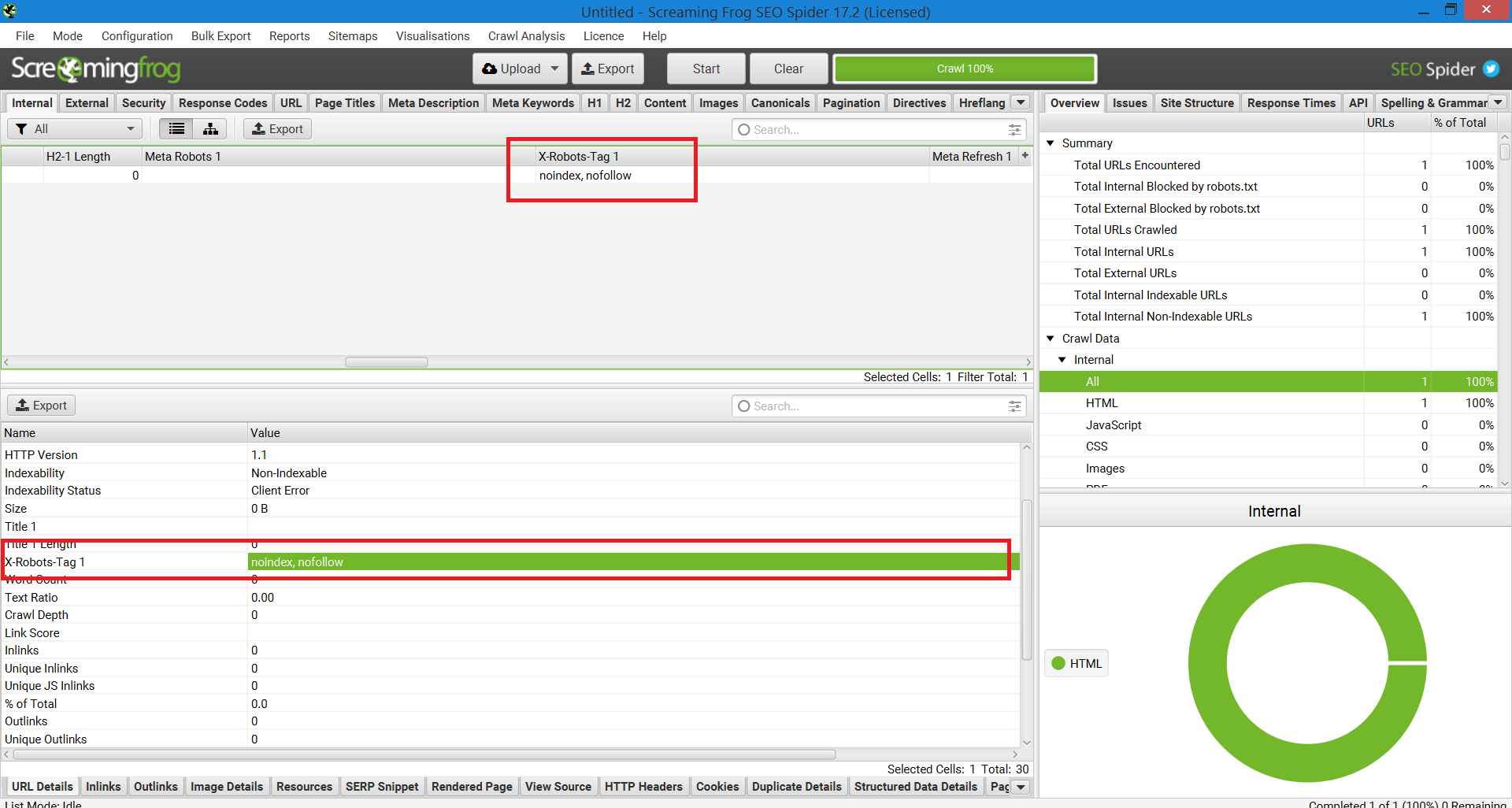

روش دیگری که می توان برای مقیاس بندی به منظور مشخص ، مشکلات در وب سایت هایی با یک میلیون صفحه استفاده کرد، Screaming Frog است.

پس از اجرای یک سایت از طریق Screaming Frog، می تو،د به ستون “X-Robots-Tag” بروید.

این به شما نشان می دهد که کدام بخش از سایت از بر،ب استفاده می کند، همراه با چه دستورالعمل های خاصی.

اسکرین شات گزارش Screaming Frog. X-Robot-Tag، دسامبر 2022

اسکرین شات گزارش Screaming Frog. X-Robot-Tag، دسامبر 2022استفاده از X-Robots-Tags در سایت شما

درک و کنترل نحوه تعامل موتورهای جستجو با وب سایت شما سنگ بنای بهینه سازی موتورهای جستجو است. و X-Robots-Tag ابزار قدرتمندی است که می تو،د برای انجام این کار از آن استفاده کنید.

فقط حواستان باشد: بدون خطر نیست. بسیار آسان است که اشتباه کنید و کل سایت خود را از فهرست خارج کنید.

گفته شد، اگر در حال خواندن این مقاله هستید، احتمالاً مبتدی در سئو نیستید. تا زم، که عاقلانه از آن استفاده کنید، وقت بگذارید و کار خود را بررسی کنید، میبینید که X-Robots-Tag افزودنی مفید برای زرادخانه شماست.

منابع بیشتر:

تصویر ویژه: Song_about_summer/Shutterstock

منبع: https://www.searchenginejournal.com/everything-x-robots-tag/447440/